Projektet PEBL (Prompt Enginering against Bias in LLM:s) har till syfte att undersöka hur metoder för prompt engineering kan användas för att minska bias hos generativa språkmodeller. Preliminära resultat från våren 2024 visar att de studerade språkmodellerna har en generell bias för traditionella könsroller, samt en allmän bias för nyligen hanterad information (sk. recency bias). Projektet PEBL syftar till att förstå orsaken till dessa bias, samt utveckla och testa prompt-metoder för att generera mer opartiska svar.

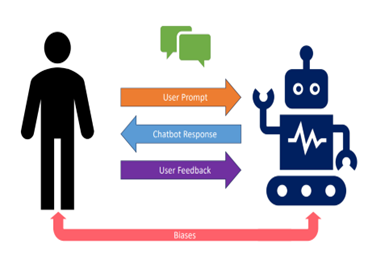

Bias, dvs. omedveten systematisk partiskhet, kan få allvarliga följder då de ger upphov till felaktigt grundade beslut. Trots att bias är en form av tankefel som vanligen tillskrivs brister i det mänskliga psyket, har det visat sig att även generativa språkmodeller producerar bias. Orsakerna till detta kan vara att det finns bias i träningsdata eller i algoritmerna som väljer ut vilken fakta som ska presenteras, och det kan även vara så att språkmodellens anpassningsförmåga gör att användarens egen bias återspeglas i språkmodellens svar.

AI-baserade tjänster och verktyg har en viktig plats i framtidens informationssystem och försvar i och med det ökade behovet av att hantera stora informationsmängder. Ett av de största genombrotten inom AI för textdata är introduktionen av GPT-baserade chatbotar. Ett användningsområde för dessa är på ett korrekt, begripligt och relevant sätt sammanfatta mängder av information från olika källor. Användaren kan påverka svaret genom hur instruktionen till chatboten formuleras. Prompt engineering går ut på att skapa relevanta, specifika och välstrukturerade instruktioner som ger så rättvisande svar som möjligt. Utveckling av bias-minimerande prompt engineering-metoder ökar förutsättningarna för en säker användning av generativa språkmodeller.

Under våren 2024 har PEBL genomfört en serie experiment med ChatGPT och Perplexity AI för att fastställa en grundnivå av bias i språkmodellerna. De preliminära resultaten visar att det hos språkmodellerna finns en bias till förmån för traditionella könsroller, och även en seriepositionsbias i form av recency effect. Fortsatta experiment syftar till att 1) förstå orsaken till dessa bias, samt 2) utveckla och testa prompt-metoder för att generera mer opartiska svar.

Projektet pågår 2024-2026. Kontaktperson är områdesansvarig Joel Brynielsson, FOI.